“统计大讲堂”第211讲回顾:过宽神经网络在一维数据上的泛化能力

2023-04-10

3月31日上午10:00,由中国人民大学统计学院和教育部人文社科重点研究基地应用统计研究中心共同举办的“统计大讲堂”系列讲座第211讲在明德主楼1016会议室举行。

本次讲座邀请清华大学统计学研究中心副教授林乾作了题为“Generalization ability of wide neural network on R”的报告。讲座由中国人民大学统计学院副院长尹建鑫主持,采用线上线下相结合的方式,吸引了校内外师生近百人参加。

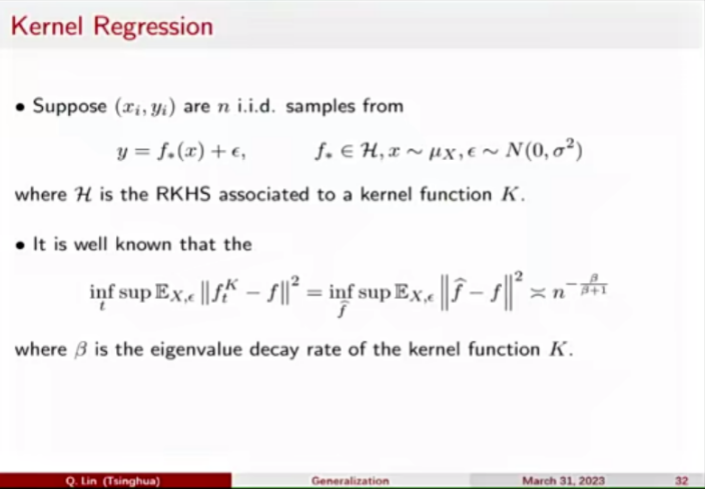

讲座的核心内容为研究宽双层ReLU神经网络在R上的泛化能力。首先,林乾从损失函数出发,提出神经网络的参数化的问题。“neural network kernel”函数证明了神经网络中kernel随时间变化。然后,林乾以Jacot的思考为例,提出解决方案,即设定中间神经网络数量趋于正无穷,可由两个方程的初值相等推出解的相似度高。因此,函数的一致收敛使NTK回归的泛化误差成为神经网络的泛化误差中最重要的部分。

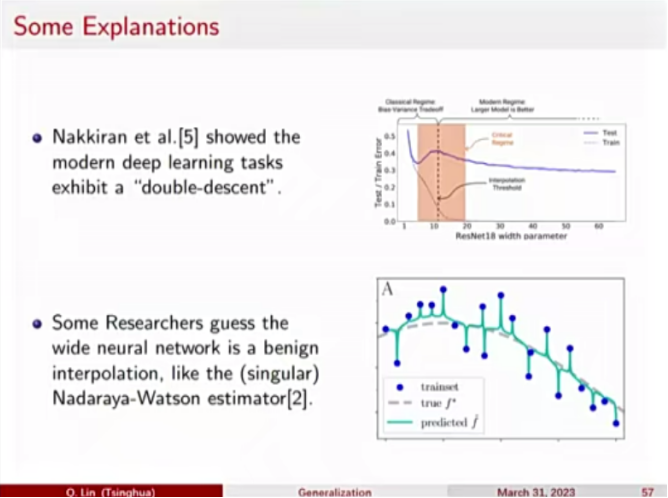

接着,林乾列举核回归方法以及神经切核回归方法,分别讲解两者的优点和缺点,以及适用领域。并得到了如下两个结论:如果在训练宽神经网络时采用早期停止策略,则得到的神经网络达到最小最大回归率,这是一种能够避免网络发生过拟合的正则化方法;如果训练神经网络直到它对数据进行过拟合,则得到的神经网络不能很好地泛化。最后,林乾提供了一个解释来调和所讲理论和广泛观察到的“良性过拟合现象”,加深了参会者对神经网络泛化应用的理解,引发师生进行深入的思考。

最后,师生踊跃向林乾提问,互动频繁,气氛轻松、活跃,林乾认真回答了师生们有关理论理解的细节问题,并就相关话题进行深入讨论。